手把手教程!使用AnythingLLM+DeepSeek 部署本地知识库

deepseek本地部署最简教程——搭建个人AI知识库

尽管本地化部署的DeepSeek模型在算力规模和功能完备性上无法媲美云端全量版本,但只要喂给它「独家秘方」——也就是我们需要使用到的文档、代码、笔记这些干货,它立马就能变身成你的专属知识小助手!当然,AnythingLLM还具备其它功能,各位可自行探索。需要注意的是,本地部署的AI回答精准度仍然受到硬件性能的制约。建议开发者根据硬件配置选择适合的模型。

1.准备

AnythingLLM。它能帮你把电脑里的文档(PDF/Word/代码文件都行)变成会聊天的知识库,操作就像把文件拖进文件夹一样简单!

用这个工具你可以:

随时提问:

保护隐私:所有资料都存在自己电脑里,不怕泄露

跨格式支持:无论是技术文档、会议记录还是代码片段都能处理

整个过程只需要三步:

把文件拖进软件

等它自动分析(喝杯咖啡的时间)

开始用自然语言提问

相当于给你的电脑配了个资料管家,当我们需要的时候随时找它!

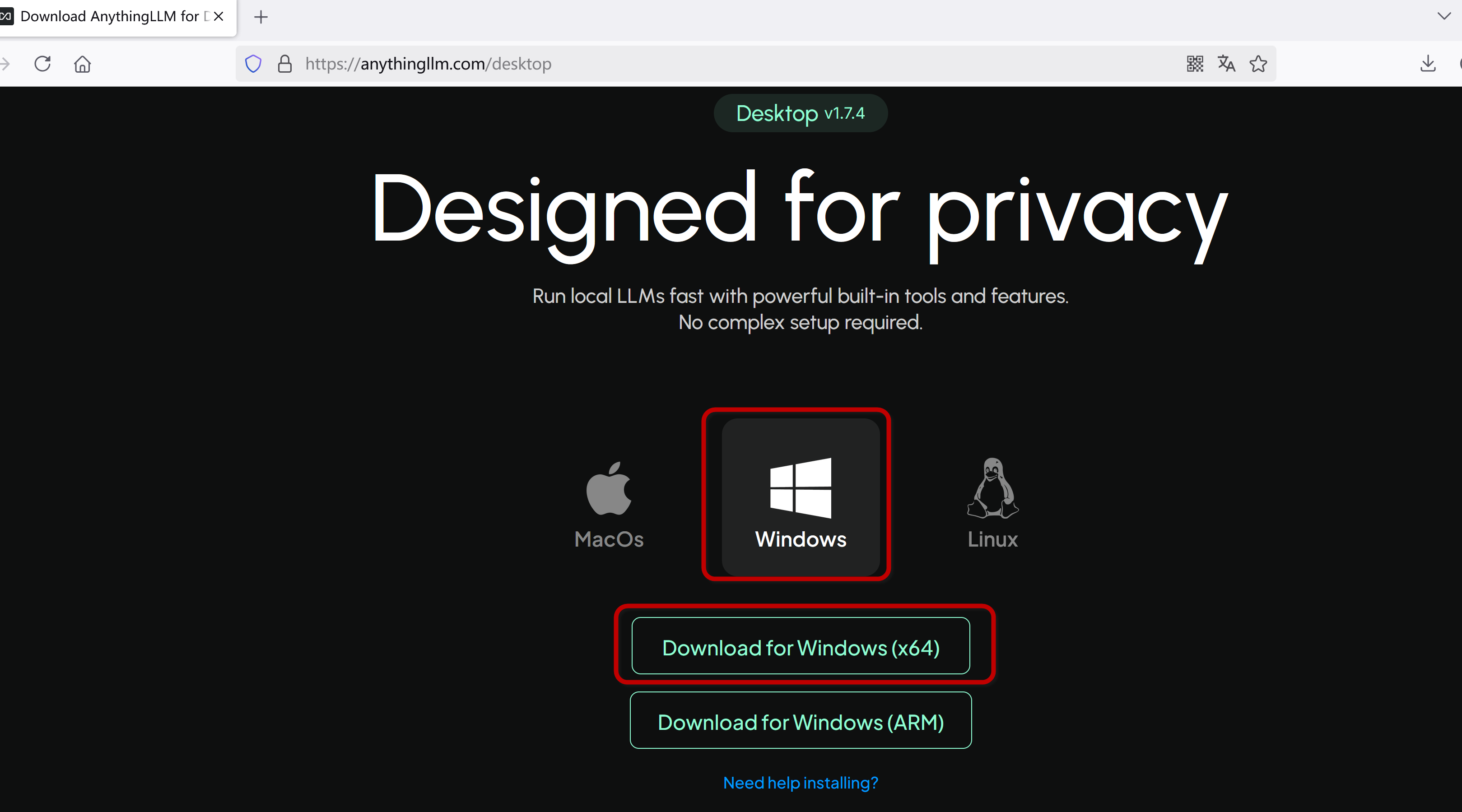

2.下载AnythingLLM

https://anythingllm.com/desktop

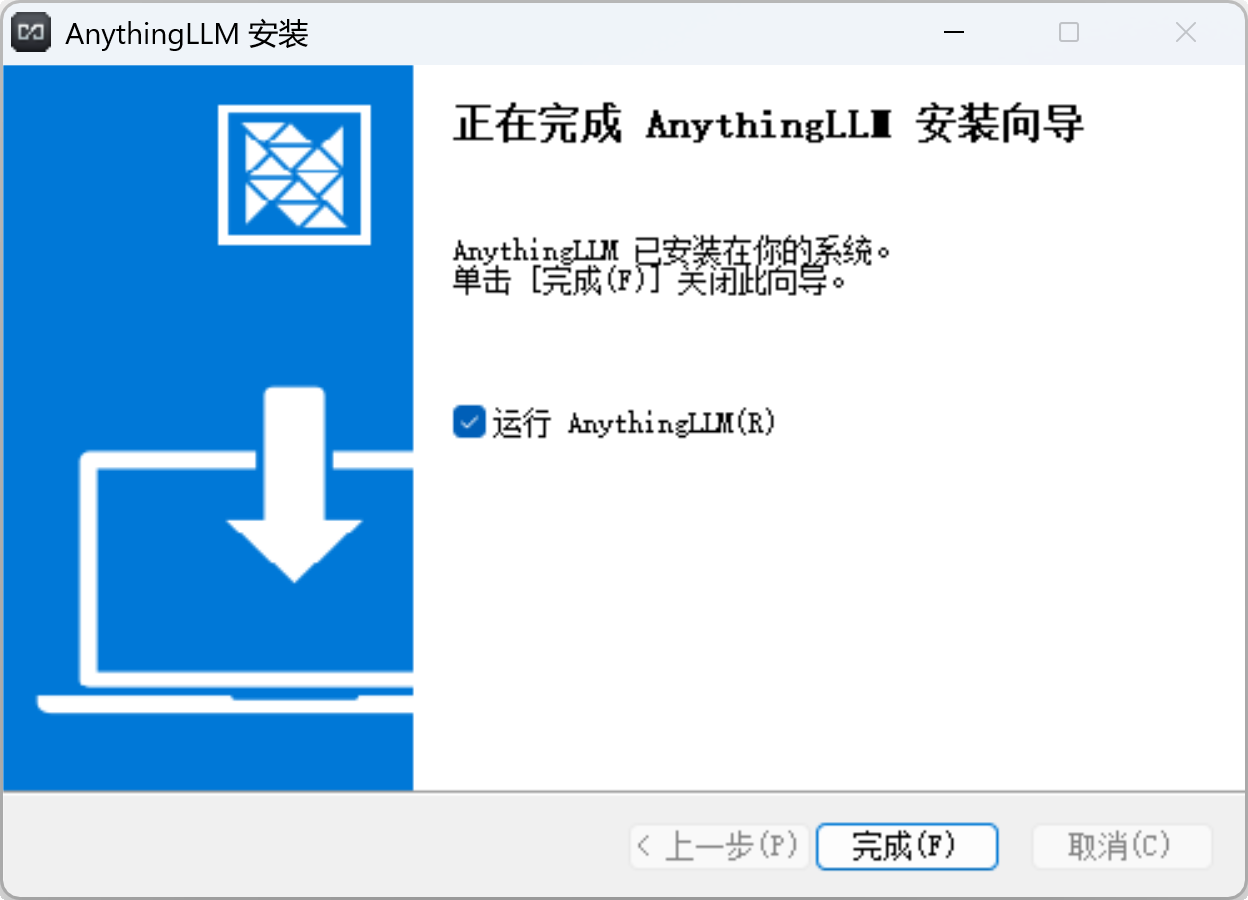

使用管理员模式运行安装程序

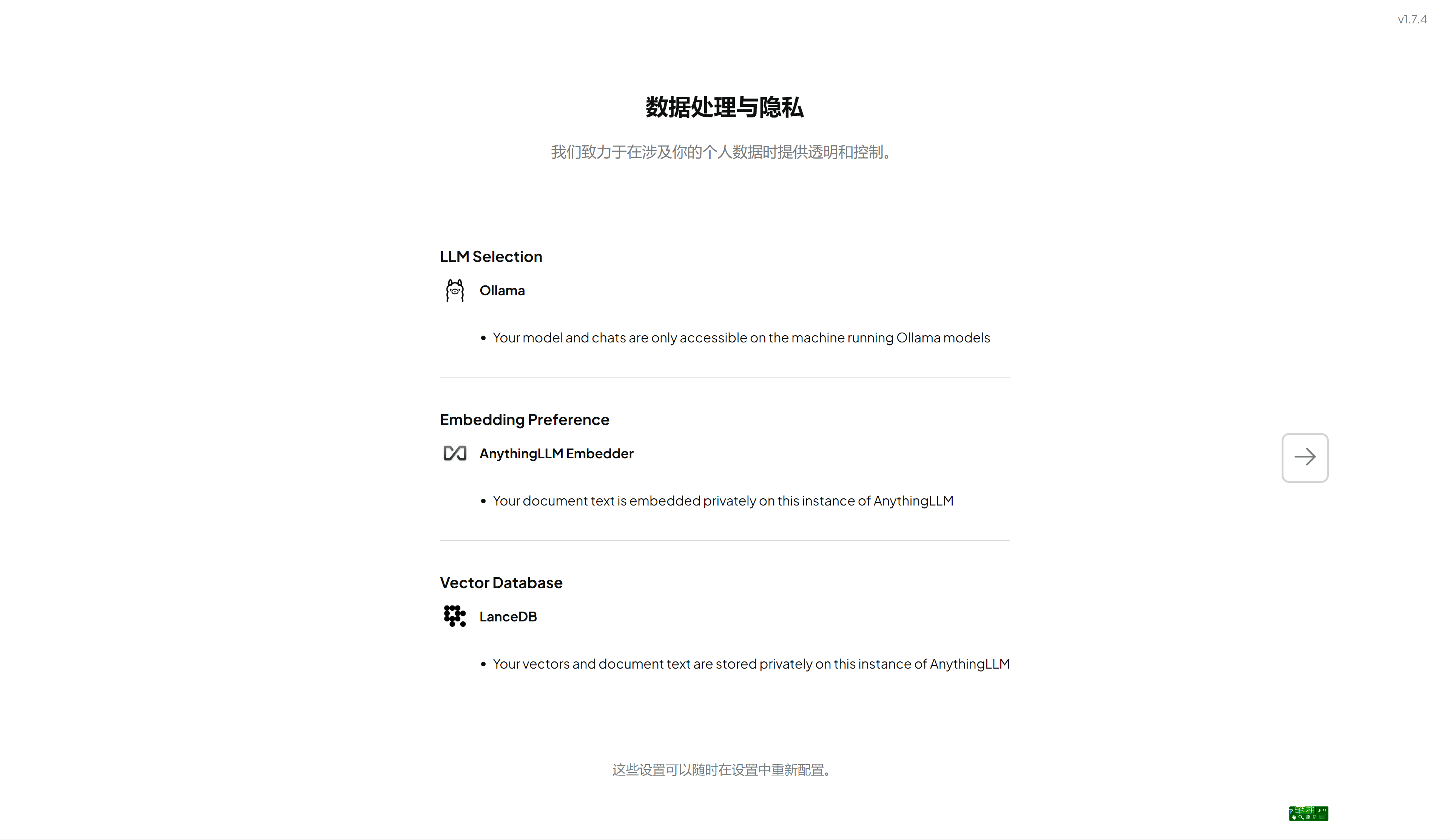

3.配置

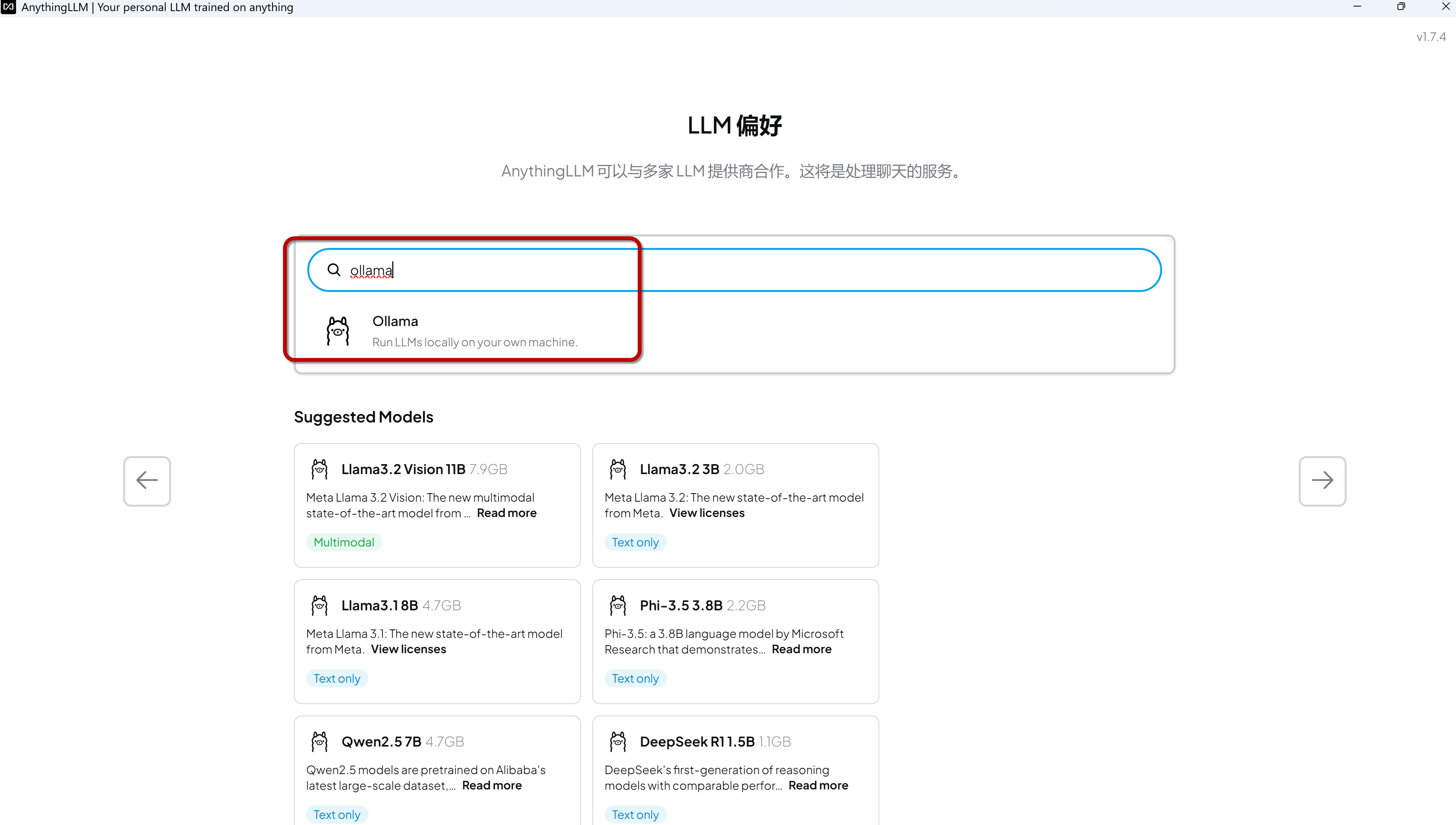

我之前已安装好ollama.先确保ollama是开启状态,然后搜索ollama

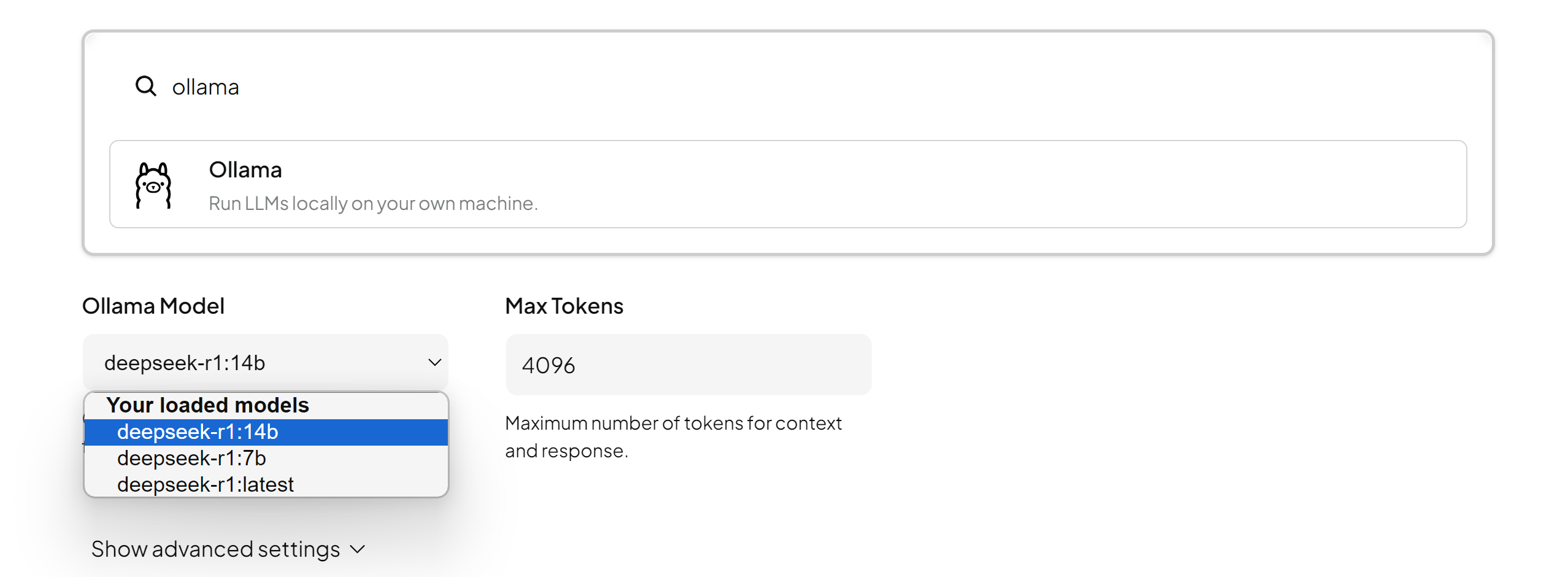

选择deepseek模型,可以根据您安装的模型版本选择

在 AnythingLLM 的本地部署配置中,MAX Token(最大令牌数) 是一个关键参数,主要用于控制语言模型(LLM)处理文本时的输入和输出长度限制。

语言模型(如 GPT)单次处理的文本长度受硬件和算法限制。MAX Token 决定了模型单次请求能处理的 输入+输出 的 Token 总数上限。超过此值会导致截断或报错。

Token 并非严格等于单词或汉字。例如,英文中 1 Token ≈ 4 字符,中文中 1 汉字 ≈ 2-3 Token

在问答或生成场景中,该参数直接影响 AI 生成回答的最大长度。例如设置为 512,则回答内容会被限制在约 512 个 Token(约 380 个汉字或 700 英文单词)。

点击下一步

填写自己的邮箱

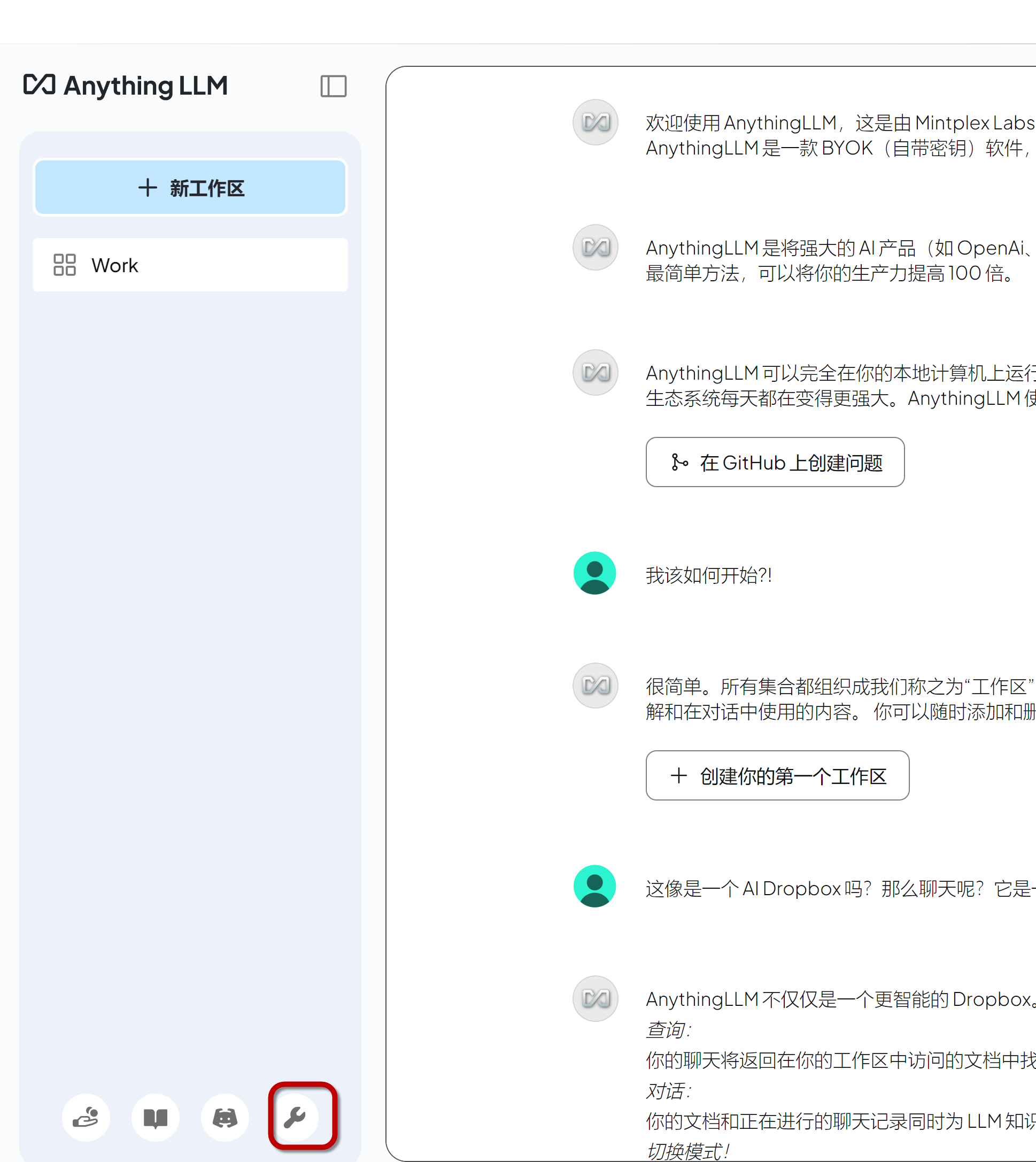

填写工作区名称

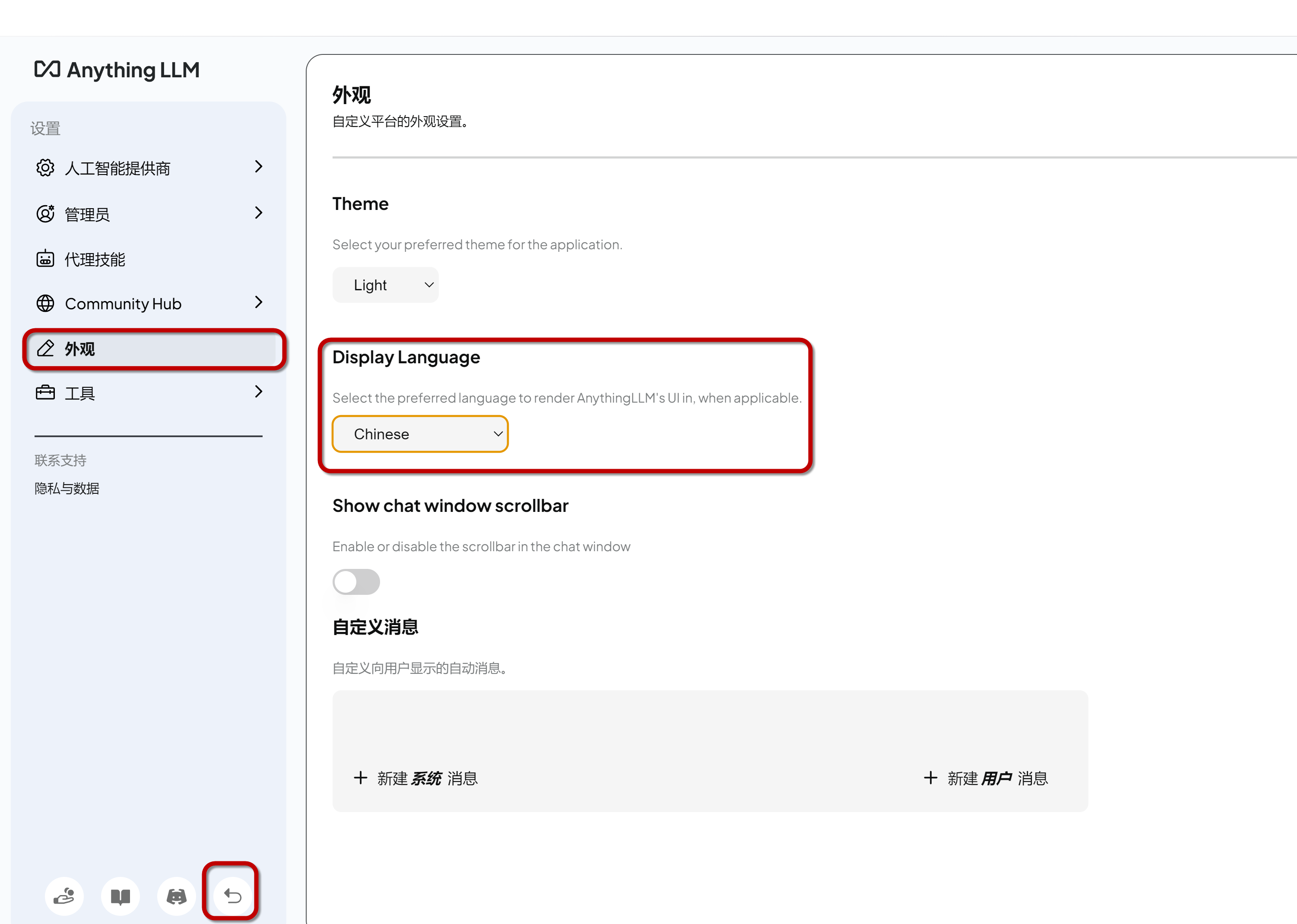

如果需要调整语言,请参考

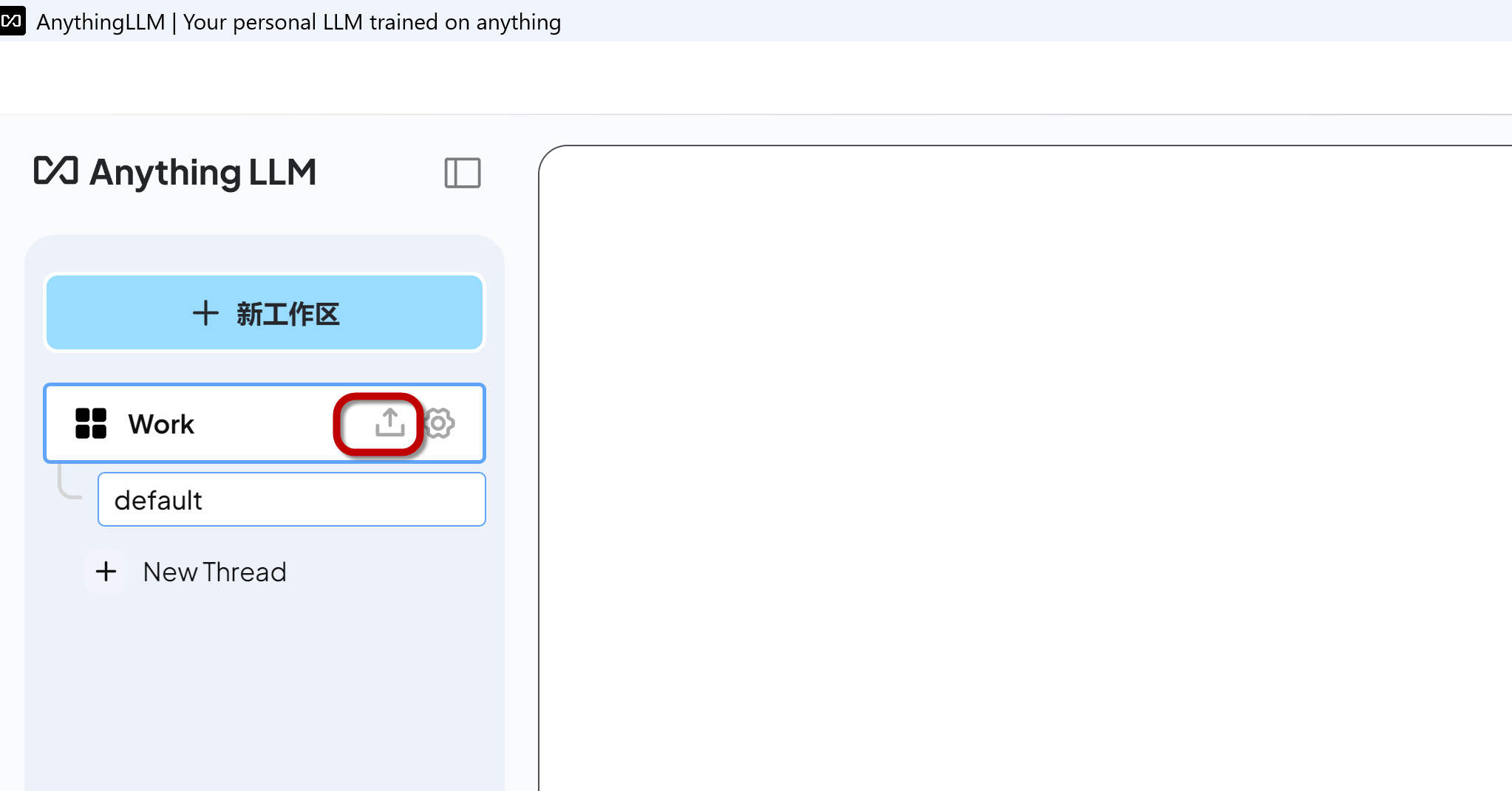

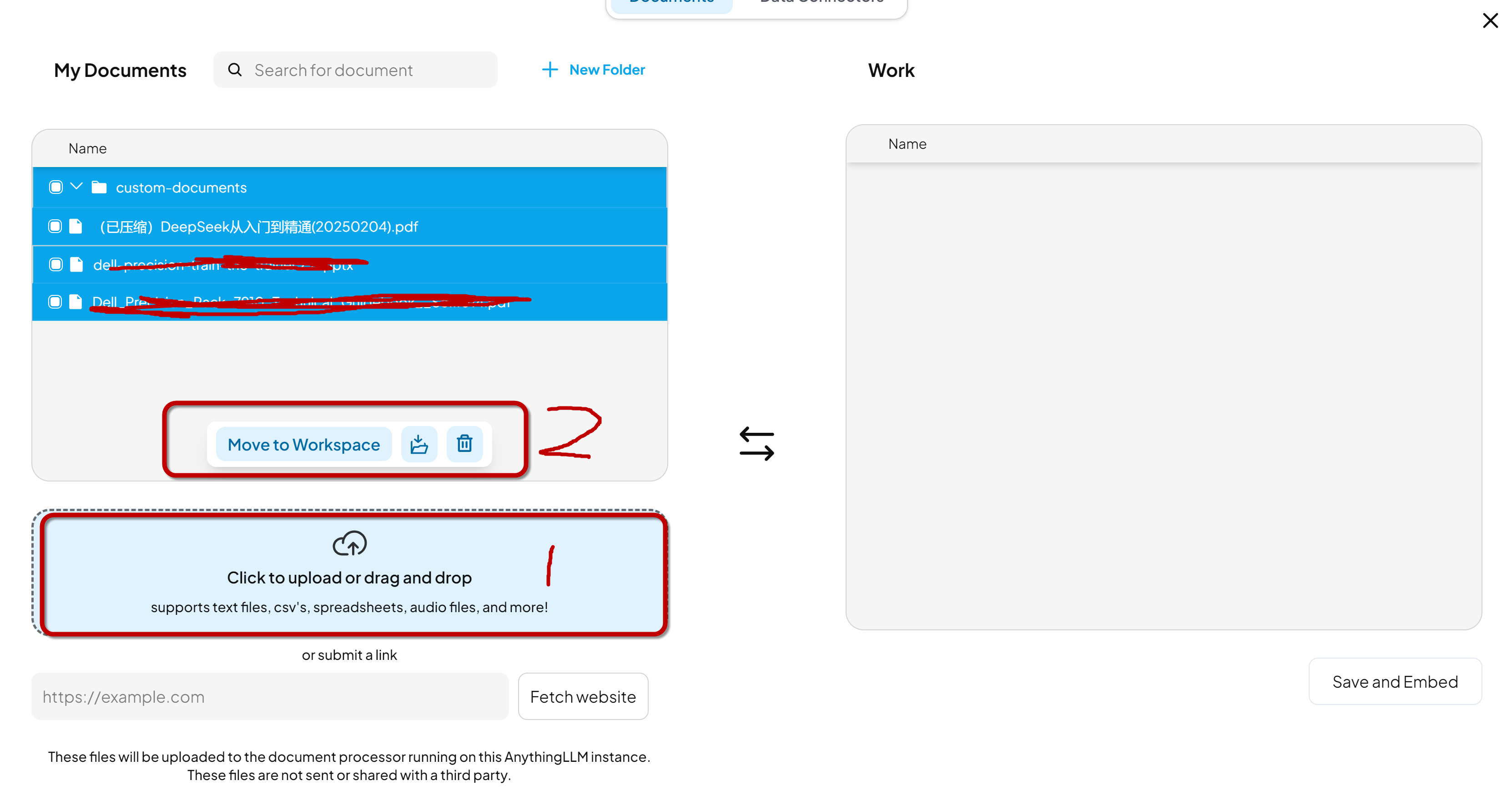

上传需要用于学习的文档

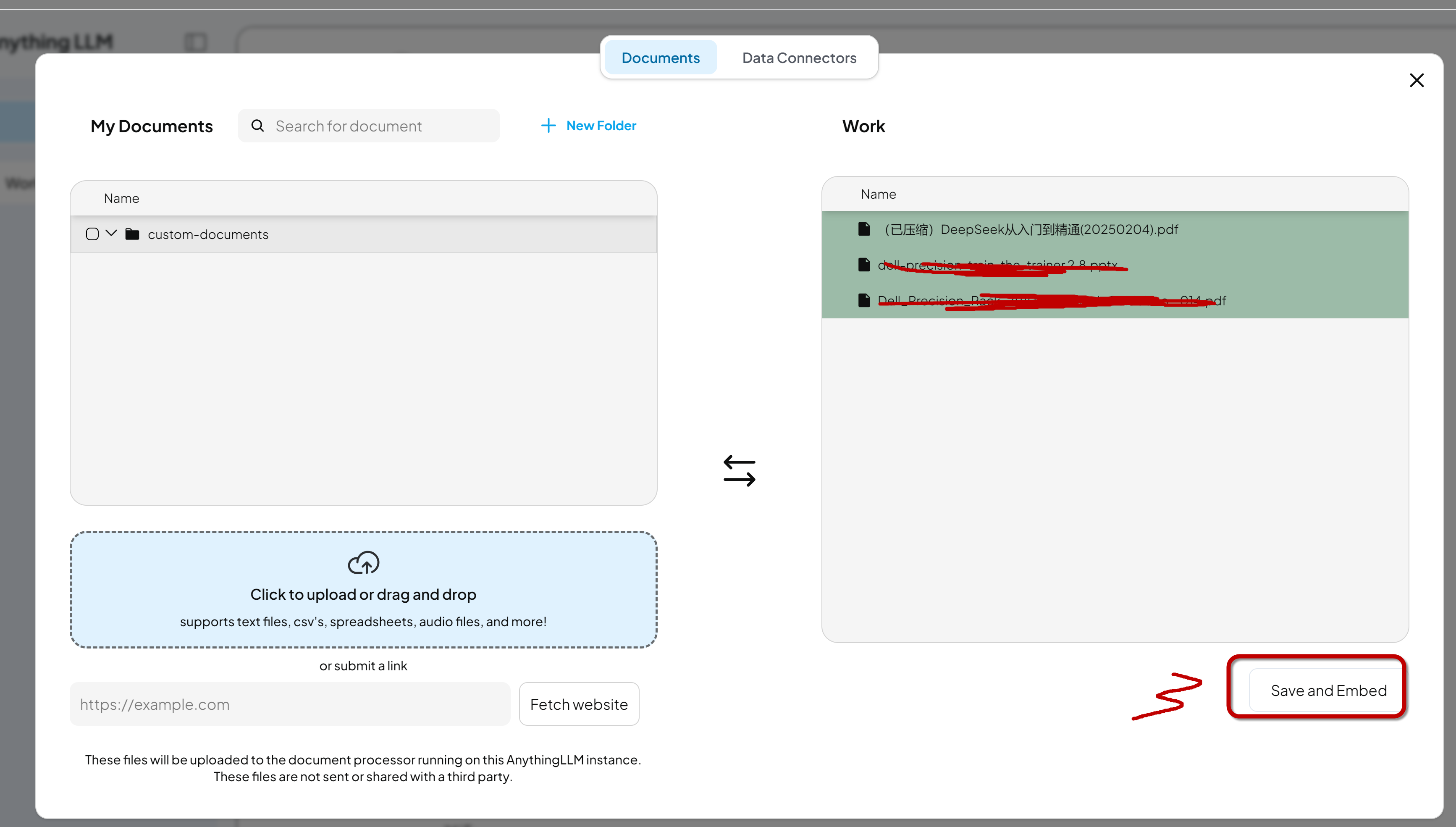

将文档放到工作区,然后移动到自己需要的工作台并保存。

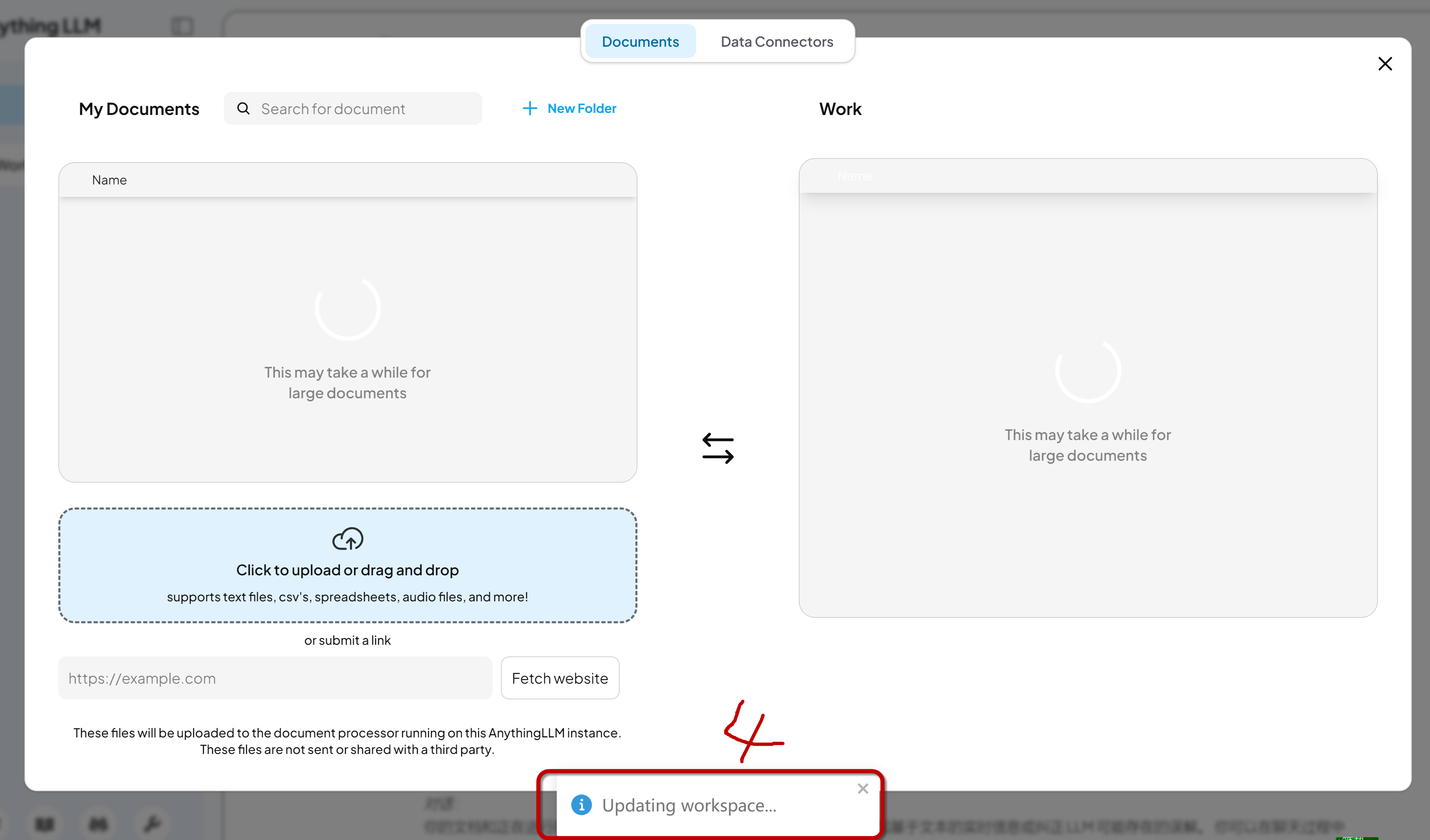

软件会自动更新您的工作台

4.测试结果

可以根据您上传的文档,提出问题,测试Deepseek的学习和理解能力,可以看到学习到了我上传的文档并列出了具体的内容。